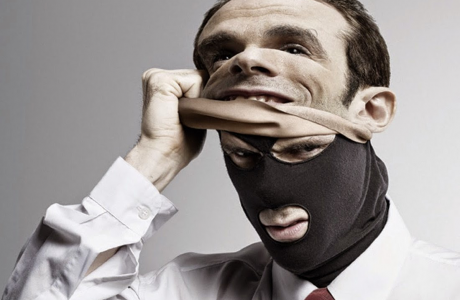

Фальшивый контент в Интернете – явление распространенное. Названия некоторых видов «цифровых фальшивок» стали даже нарицательными – например, словечко «фотошоп», означающее фальшивое изображение (по названию популярного графического редактора, в котором многие такие фальшивки и делали). Но если фотографиям в Сети современный пользователь доверяет слабо, а текстам онлайн-СМИ – с оговорками, то видео пользовалось априорным доверием, и слово «видеоролик» чуть не стало синонимом понятия «видеодоказательство». Так было до недавнего периода.

Период этот в то же самое время был периодом прогресса в создании искусственного интеллекта. До «Скайнета», конечно, нам пока по-прежнему далеко, но вот обучаться на основе кучи изображений и достоверно воспроизводить мимику и движения искинт уже научился. Именно это свойство ИИ было взято «на вооружение» создателями видеофальшивок совершенно нового уровня достоверности.

Если изложить «хитрую» технологию максимально простыми словами, то суть действий жуликов выглядит примерно так. Сначала оцифровываются действия и движения одного человека – они выступят «каркасом», на который «наложат» оцифрованную внешность другого человека, «нужного». Достоверное изменение мимики и отображение всех участков тела обеспечит нейросеть, прогнозирующая, что и как конкретно должно измениться – скажем, в лице – при определенном телодвижении. При достаточном количестве изображений «нужного» человека в распоряжении нейросети на выходе получается видео потрясающей степени достоверности – выше, чем при использовании живых «двойников».

Устоявшегося названия у этой угрозы пока еще нет – условно ее называют Deep Fake, от сочетания слов Deep Learning (глубокое машинное обучение) и Fake (фальшивка). А вот устоявшиеся способы ее применения уже обозначились. Первоначально технологию создавали для Голливуда – чтобы успешно делать ремейки тех же «Звездных войн» с внешностью принцессы Лейи из оригинальных серий саги. Заинтересовались ей и новостные студии – эти увидели выгоду в использовании «оцифрованного ведущего» передачи. Однако стоило технологии «подешеветь», и она массово пошла в «широкий повседневный оборот», где ей быстро нашли противоправное применение.

В первую очередь, разумеется, речь идет о фальшивой порнографии. Сначала Deep Fake начали применять для создания порнографических роликов со знаменитостями – их видеоизображений в сети чрезвычайно много, и со «скармливанием» их нейросети никаких проблем. Но позднее, в 2018 году, сервисы на основе данной технологии стали доступны чуть ли не каждому пользователю – например, их предлагали отдельные всемирные социальные сети, не говоря уже об отдельных ресурсах «немного не на той стороне закона». Итогом этого стал рост количества «порнографии из мести» — когда некий обиженный партнер делал фальшивое интимное видео с изображением другого партнера и запускал его в оборот в целях компрометации. Обычно этим «развлекались» подростки и молодежь. Хотя, впрочем, фабрикацией других видов киберунижения они тоже не брезговали – например, созданием фальшивок некоего унижающего жертву поведения. Возможно и применение Deep Fake технологии в экстремистских или террористических целях – но это уже совсем особая история, хотя некоторые фантасты ее предсказывали еще 80 лет назад.

Главная проблема с таким способом «компрометажа» заключалась в априорном доверии пользователя к видео. «Это же не фотография», — рассуждает обычный юзер. – «Ее не отфотошопишь. А внешность тут твоя, даже если видео и монтировали». Поэтому жертве крайне трудно убедить зрителей, что перед ними высокотехнологичная фальшивка – ей не верят. С ней перестают общаться, накладывают официальные санкции… Итог – неврозы и попытки суицидов, от невозможности доказать свою правоту.

С другой стороны, появление подобной угрозы означает, что теперь мы не можем верить видео в принципе. И это позволяет ставить под сомнение даже видеодоказательства в уголовном процессе – осведомленный адвокат может легко сказать, что другая сторона представила Deep Fake. При этом какого-то средства определения таких фальшивок, наподобие антивирусу, пока просто-напросто нет. Отдельные разработчики спешно объявили о создании приложений, якобы способных распознавать Deep Fake – например, в конце июня 2019 года ученые из Института информационных наук США объявили о создании инструмента, якобы распознающего Deep Fake с вероятностью 96%. Смущает в этих сообщениях то, что среди них нет ни одного признанного разработчика защитного ПО, а в американской новости речь идет все о той же технологии машинного обучения – только теперь нейросеть «обучили» изначально фальшивым видео и попытались заставить ее увидеть соответствующие закономерности.

Помимо презумпции недоверия к видео в Сети, «умные фальшивки» порождают еще одну проблему – пересмотра политики доступности своих персональных данных в Интернете. Не секрет, что многие публикуют в соцсетях сотни своих фото и часы видео, при этом все это находится в открытом доступе. А, по данным британских специалистов, нейросети для создания фальшивки нужно от 300 до 2000 статичных изображений. Восьми же часов видео оказывается достаточно вообще для научного открытия в сфере машинного обучения – не то что для «фальшивки из мести».

Спасает пока только одно: deep fake на просторах Интернета пока встречается довольно редко. Сервисы, пытавшиеся предложить своим пользователям нечто подобное «ради развлечения», быстро сообразили, какого джинна они выпускают из бутылки – и соответствующие приложения оперативно убрали. Однако их доступность только «на темной стороне» лишь минимизирует проблему, но не решает ее – тем более что в отдельных странах все больше и больше пользователей «переходят на темную сторону» просто ради обхода блокировок, узнавая при этом о ней все больше и больше. Поэтому без перестройки восприятия видеоконтента безопасного будущего уже не получится.

Как же должно перестроиться это восприятие? Для начала, нужно помнить: любое видео может оказаться сфальсифицированным. Даже если ты не чиновник и не бизнесмен, а всего лишь восьмиклассник. Поэтому выносить какие-либо суждения просто на основе видеоролика сейчас преждевременно – до полноценного исследования техническими специалистами. Причем это касается всех – подростков, родителей, учителей и директоров школ. И относиться к таким видео лучше как к обычным сценам киберунижения.

А что делать с киберунижением – мы все знаем. Обращаться к администрации сервиса с просьбой прекратить оборот такого видео. Также в этом всегда может помочь «Горячая линия». Для аналитиков контента главный момент – не как это было сделано, а что там изображено. И унижающий контент просто-напросто исчезнет из публичного пространства.

Линия помощи

Линия помощи Горячая линия

Горячая линия